小互日报-2 月 17 日

type

status

summary

date

slug

tags

category

password

icon

1⃣️

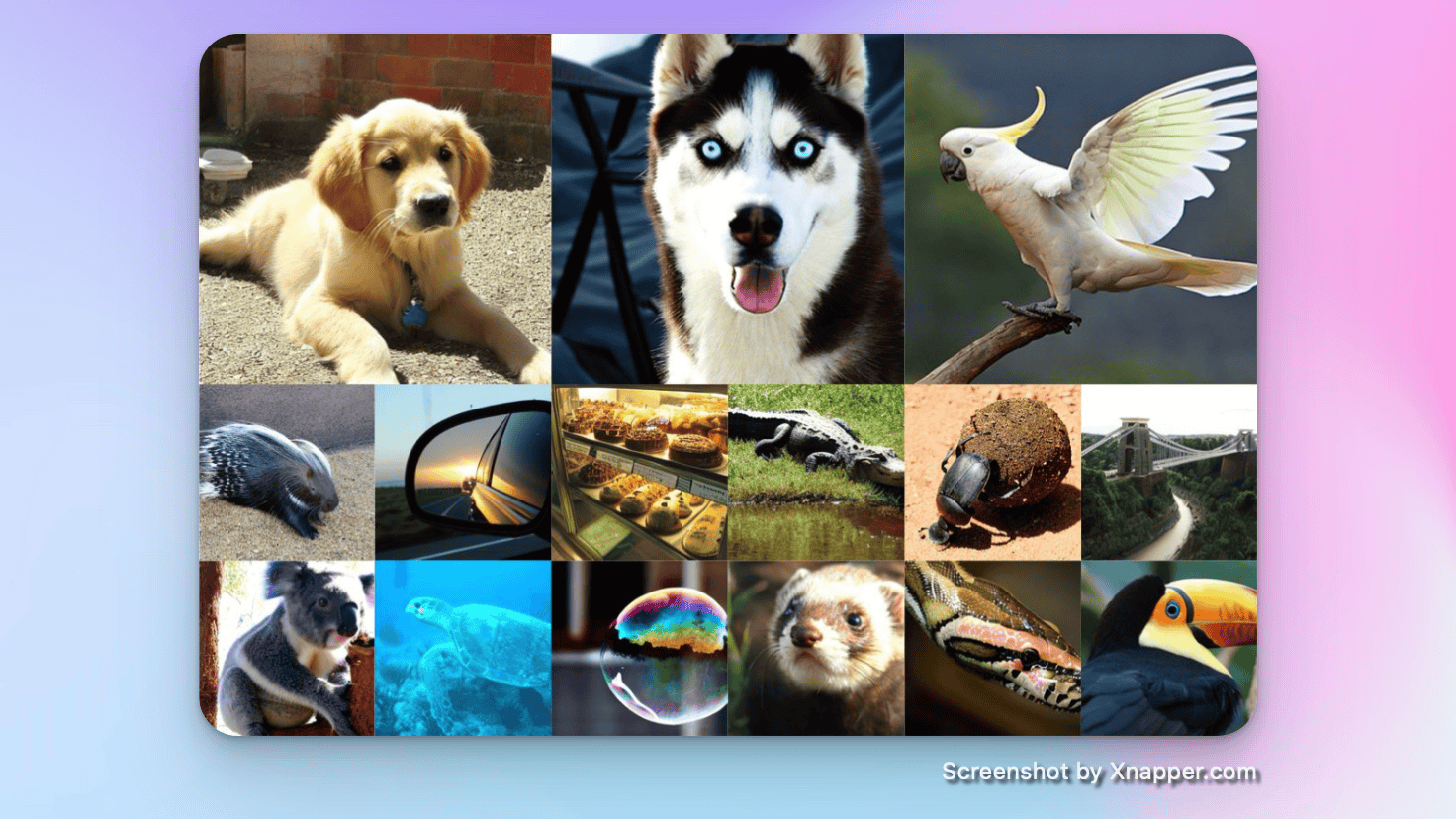

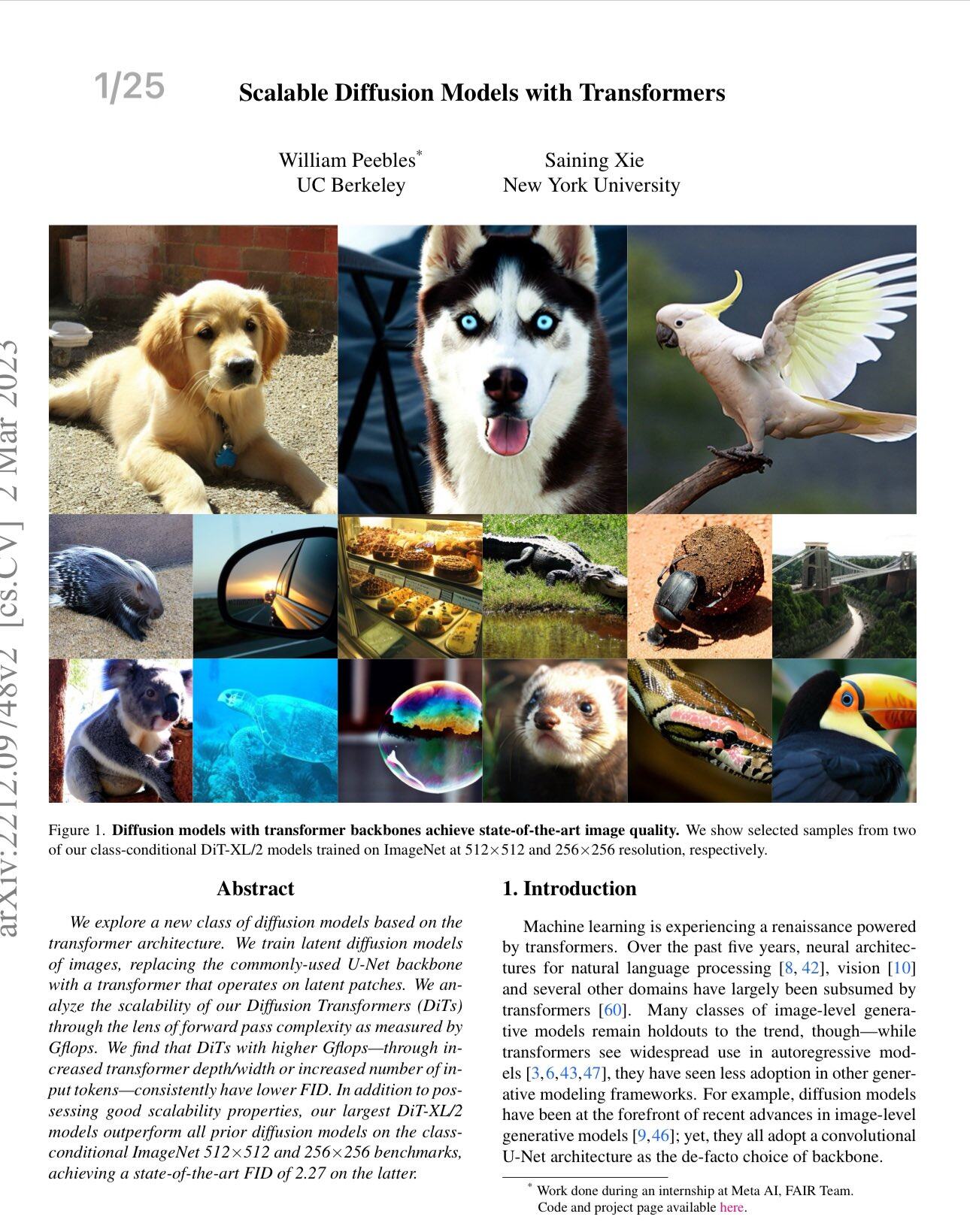

🔬Sora的核心技术和发展:

这是一个2022年12月由伯克利和纽约大学两位研究人员提出的模型,目前这两位一个在Meta AI,一个在OpenAI…

根据其中一个作者@sainingxie(目前就职于Meta AI),根据他他提供的深入分析,Sora是一个基于DiT的混合模型,包含VAE、ViT、DDPM。

自编码器(VAE):用来处理视频数据,使得视频在生成时可以保持时间上的连贯性。

视觉变换器(ViT):让模型更灵活地处理不同的视频数据,比如可以只关注视频中的某些特定部分。

DDPM:帮助生成更高质量的视频。

•Sora的”视频压缩网络”实质上是一个在原始视频数据上训练的VAE,其中标记化对于保持良好的时间一致性很关键。

•在DiT项目中,强调了简单性和可扩展性。ViT的灵活性使模型在处理输入数据时更加灵活,而Sora展示了DiT的缩放定律也适用于视频。

•Sora的关键进展包括其”新兴模拟能力”,特别是在长视频生成方面的突破,以及对训练数据来源和构建的讨论缺失。

其他技术细节与推测:

• Sora可能还使用了Patch n’ Pack(NaViT)来适应不同的分辨率、持续时间和宽高比。

• NaViT模型: 提出了一种新的视觉变换器,能够处理任意分辨率和纵横比的输入,摆脱了传统上需要将图像调整到固定分辨率的限制。

• 灵活性和效率: NaViT不仅在使用上提供了灵活性,还在大规模的监督学习和图像-文本对比学习中展示了提高的训练效率。

• 跨任务应用能力: NaViT能够被高效地迁移到包括图像和视频分类、对象检测、语义分割等标准视觉任务,并在这些任务上取得了优异的性能。

• 推理时的灵活性: 在推理阶段,NaViT允许根据需要灵活调整输入分辨率,以在计算成本和模型性能之间找到最佳平衡。

Patch NaViT论文:

对于视频质量的推测,基于模型大小和计算量的估算,Sora可能拥有约3B参数,这表明训练Sora模型可能不需要预期的那么多GPU,预计将有非常快的迭代。

最新进展:

DiT在Sora中的应用表现出色,NYU的团队最近发布了一个新的DiT模型,称为SiT,具有相同的架构但提供了更高的性能和更快的收敛速度,对其在视频生成上的表现表示出了浓厚的兴趣。

DiT项目地址:

论文:

GitHub:

2⃣️

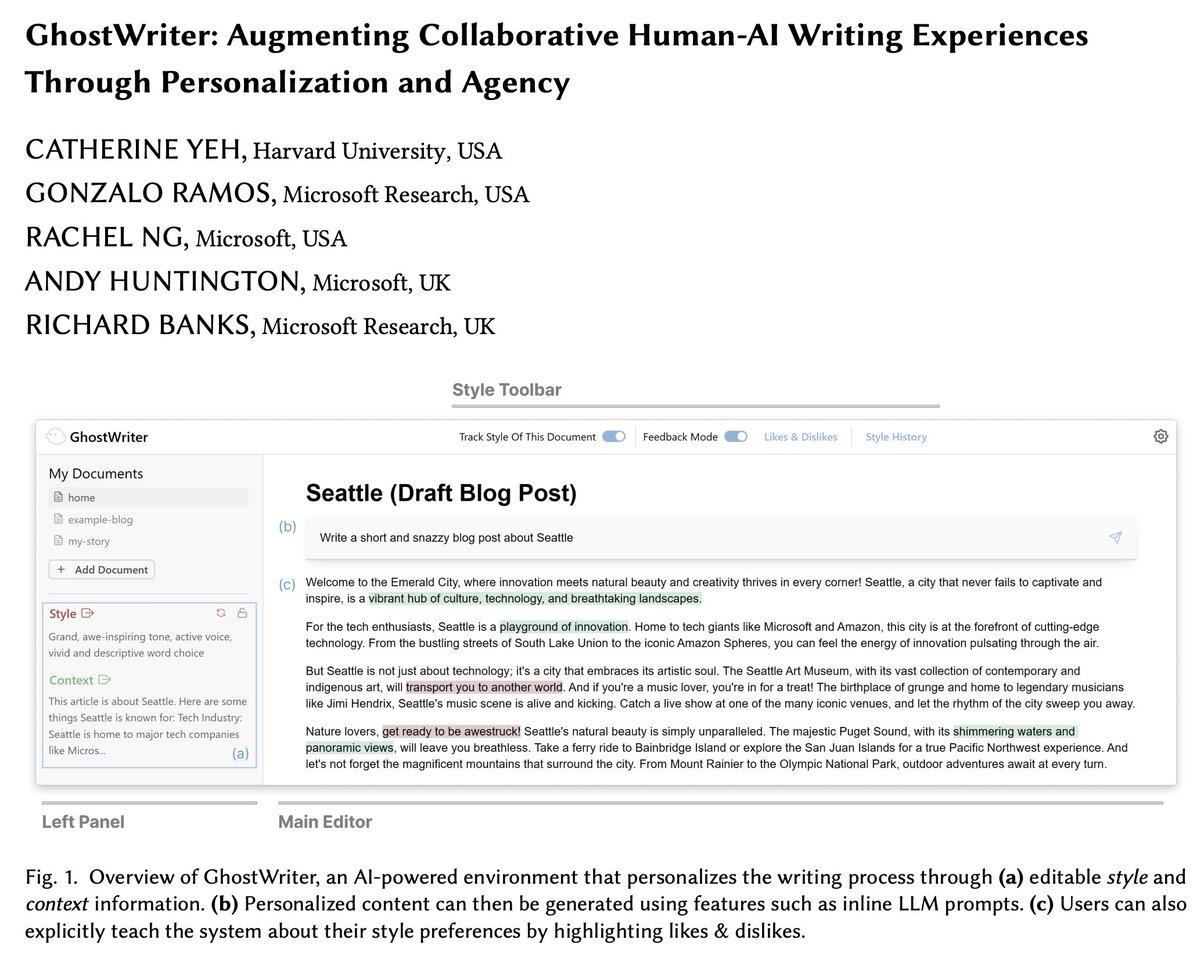

✍️GhostWriter:个性化的AI写作工具:

- 由哈佛大学和微软研究院共同开发,基于ChatGPT。

- 学习和应用用户的写作风格,提供个性化文本生成。

- 经研究证实,提升了用户的满意度和参与度。

🔗 https://arxiv.org/abs/2402.08855

🔗 https://x.com/xiaohuggg/status/1758704157014569178?s=20

3⃣️

📖ReadAgent:Google开发的阅读代理:

- 模仿人类阅读方式,处理长文本。

- 采用忘记具体信息但保留要点的策略,提高理解效率。

🔗 https://read-agent.github.io

🔗 https://x.com/xiaohuggg/status/1758700080394285453?s=20